Discovery:

Мультимодальная кросс-форматная

контентная

модель

01

Разбираем видео на части

Каждое видео содержит несколько источников информации — модальностей: заголовок, описание,

визуальный ряд, аудиодорожку и статичную обложку. На этом этапе мы структурируем контент —

выделяем отдельные модальности, чтобы затем каждую из них можно было обработать специальными

алгоритмами.

Обложка

Аудио

Видео

Название и описание

02

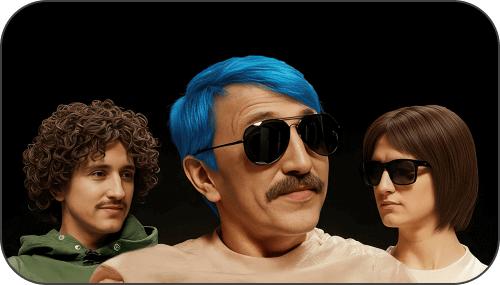

Извлекаем скрытые сигналы

Мы применяем нейросетевые модели для извлечения скрытых сигналов: распознаем популярных

персон в кадрах, извлекаем надписи и субтитры из видео, преобразуем речь в текст. Так

создается максимально полное представление о содержимом ролика, выходящее за рамки исходных

данных.

Название

Описание

Обложка

Видео

Аудио

Популярные персоны

«и все таки это ваше такое хобби было, конечно, я отец, у меня»

Текст на видео

03

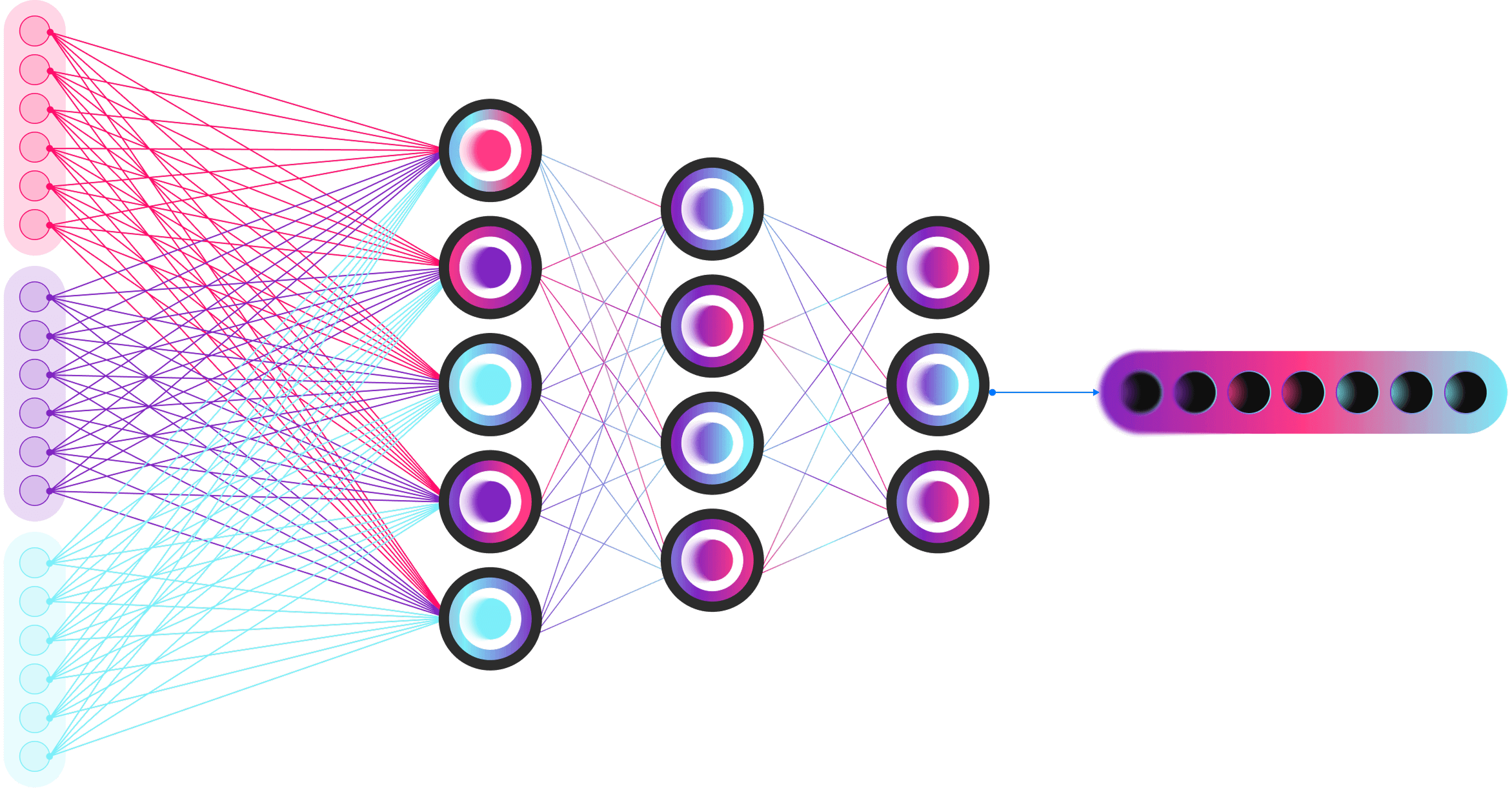

Переводим в язык чисел

Для каждой модальности используется свой энкодер: языковые модели обрабатывают текст,

визуальные модели анализируют изображение и видеоряд, акустические — аудиосигнал.

В результате мы получаем эмбеддинги — числовые представления, унифицирующие данные

разной

природы в едином пространстве признаков.

Название

Описание

Речь

Видео

Обложка

Текстовый энкодер

Видео энкодер

Визуальный энкодер

Эмбеддинги

Эмбеддинги

04

Собираем единый

образ контента

образ контента

На финальном этапе нейросеть объединяет эмбеддинги всех модальностей и формирует комплексное

представление контента — мультимодальный эмбеддинг. Он аккумулирует разнородные сигналы и

отражает содержание и смысл ролика, что помогает более точно решать задачи рекомендаций,

поиска и аналитики.

Эмбеддинг

с мультимодальной

информацией

с мультимодальной

информацией